But why writing books ?

Un séminaire pluriannuel coordonné par Jean-Sylvestre Bergé, Anthony Hussenot et Maxime Menuet.

Mais pourquoi écrire des livres ? Quelle est notre motivation et notre expérience dans ce domaine et comment la partager dans le cadre de la pluridisciplinarité (droit, économie, gestion, sociologie) de notre laboratoire ?

Le séminaire Gredeg Books a pour objectif de présenter les travaux des membres du Gredeg, de discuter de la place du livre dans nos disciplines, ainsi que des processus d'écriture et de publication.

Il s'agit d'un séminaire pluriannuel structuré autour de deux sessions par an. Pour chaque session, des auteurs de différentes disciplines présenteront leur travail et un moment d'échange sera organisé entre les auteurs et les participants.

In the life of an academic profession, scientific contribution most often means writing journal articles. However, sometimes we choose to embrace the format of a book and thus place our reflection in a longer space and time.

But why writing books ? What is our motivation and experience in this domain and how can we share it in the context of the pluridiciplinarity (law, economics, management, sociology) of our laboratory ?

The Gredeg Books seminar aims to present the work of Gredeg members, to discuss the place of books in our disciplines, as well as the writing and publication processes.

This is a multi-year seminar structured around two sessions per year. For each session, authors from different disciplines will present their work and a moment of exchange will be organized between the authors and the participants.

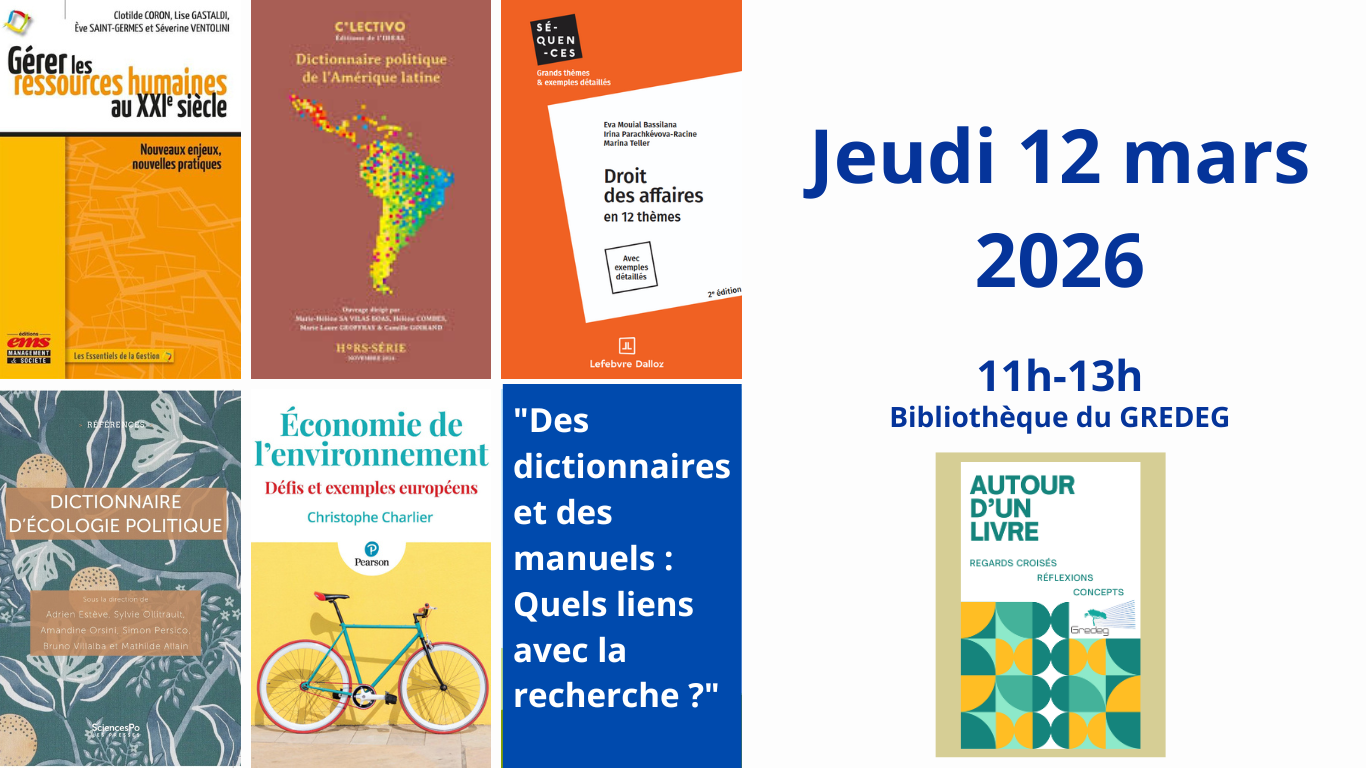

4ème séminaire

Mars 2026 - 11h

Bibliothèque du GREDEG

Jean-Sylvestre Bergé : Président de séance

Clotilde Coron, Lise Gastaldi, Ève Saint-Germes, Séverine Ventolini

Dictionnaire politique de l'Amérique latine

Hélène Combes, Marie-Laure Geoffray, Camille Goirand, Marie-Hélène Sa Vilas Boas

Droit des affaires en 12 thèmes

Eva Mouial-Bassilana, Irina Parachkevova-Racine, Marina Teller

Dictionnaire d'écologie politique

Adrien Estève, Sylvie Ollitrault, Amandine Orsini, Simon Persico, Bruno Villalba, Mathilde Allain

Économie de l'environnement - Défis et exemples européens

Christophe Charlier

3ème séminaire

Juin 2025 - 14h00

Bibliothèque du GREDEG

Anthony Hussenot : Président de séance

L'innovation au cœur des territoires

Sustainable Freedom

En cours d'édition

2ème séminaire

Janvier 2025 - 13h30

Bibliothèque du GREDEG

Jean-Sylvestre Bergé : Président de séance

AUTEURS

Franck COCHOY, Gerald GAGLIO, Anaïs DANIAU

Le masque sanitaire sous toutes ses coutures

Anthony Hussenot (Discustant)

1er séminaire

Septembre 2024 - 10h

Bibliothèque du GREDEG

Maxime Menuet : Président de séance

10h-10h45 : Jean-Luc Gaffard (Auteur)

Instabilité et résilience

des économies de marché

Jean-Sylvestre Bergé (Discustant)

VENDREDI 6 SEPTEMBRE

10h45-12h30 : Laurence Saglietto (Auteur)

Mai-Anh Ngo

L'acceptabilité sociale

Anthony Hussenot (Discustant)